“Su capacidad de razonamiento está hinchada”

Teknalix febrero 20, 2025 No hay comentarios

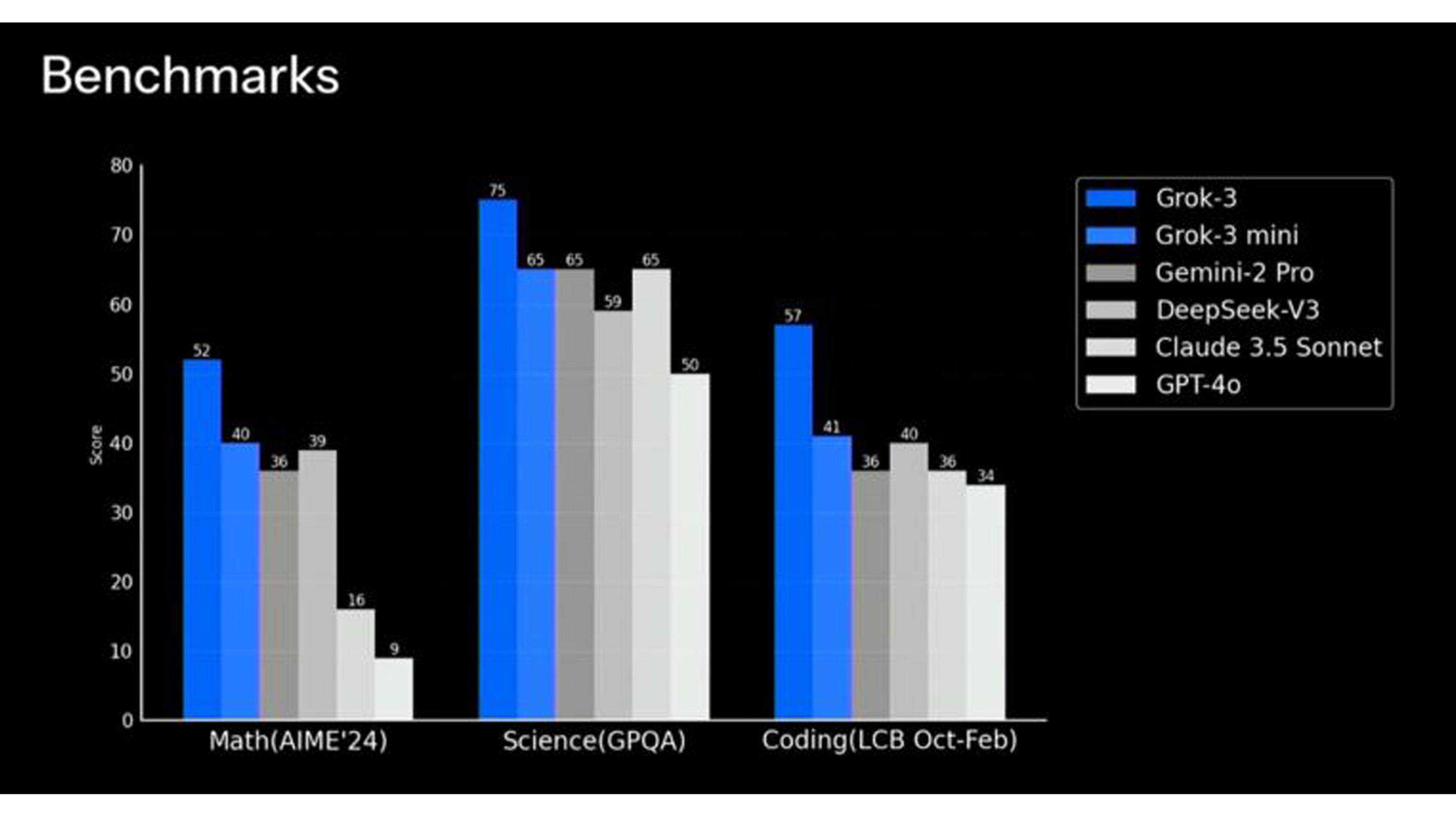

Elon Musk y su empresa xAI han promocionado Grok 3 como “el chatbot más inteligente del mundo”, asegurando que su razonamiento lo coloca por encima de la competencia. Sin embargo, expertos en inteligencia artificial han puesto en duda estas afirmaciones. La evaluación de modelos de IA es un campo altamente competitivo y no siempre los resultados reflejan la realidad.

El catedrático Julio Gonzalo, junto a otros investigadores, realizó un experimento que revela las limitaciones de estas pruebas como los benchmarks, según El País. En lugar de presentar respuestas directas en un test de elección múltiple, reemplazaron las opciones correctas con una respuesta genérica como “ninguna de las anteriores”.

Con este pequeño cambio, la precisión de los modelos cayó hasta un 57%, evidenciando que los chatbots no razonan realmente, sino que buscan coincidencias en los datos con los que fueron entrenados.

El marketing de la IA y la percepción pública

Los benchmarks son pruebas estándar utilizadas para medir el rendimiento de los chatbots en tareas específicas. Aunque pueden ofrecer una comparación rápida entre modelos, también pueden ser objeto de manipulación.

Las empresas desarrolladoras tienen acceso a estos test y pueden entrenar sus modelos para obtener los mejores resultados, sin que esto implique una mejora real en su capacidad de razonamiento.

Social Geek

El problema principal de los chatbots actuales es que dependen de ingentes cantidades de datos previamente recopilados. Durante su fase de entrenamiento, procesan información masiva disponible en internet, lo que les permite reconocer patrones y predecir respuestas. Sin embargo, esto no significa que comprendan el significado de lo que dicen.

La investigación de Gonzalo muestra que cuando un chatbot se enfrenta a una situación en la que no puede basarse en datos preexistentes, su rendimiento cae drásticamente. Esto indica que el razonamiento real sigue siendo un desafío para la inteligencia artificial actual.

Aunque estos modelos pueden ofrecer respuestas coherentes, a menudo lo hacen de forma superficial, sin una verdadera comprensión de los temas que abordan.

El experto explica que “su capacidad de razonamiento está hinchada” y que avanza a un ritmo más pausado de lo que los departamentos de marketing y expertos en promoción quieren hacer creer.

“Nuestros resultados demuestran que los chatbots, en general, siguen aplicando un tipo de razonamiento intuitivo y tienen una capacidad de generalización escasa. En otras palabras, siguen contestando de oídas, intuitivamente, y siguen siendo, en esencia, súpercuñados que lo han leído todo, pero no han asimilado nada”, indica Gonzalo en el estudio.

El mundo de la inteligencia artificial es altamente competitivo y cada empresa busca posicionar su modelo como el más avanzado. Musk y xAI han apostado fuerte por Grok 3, promoviendo su superioridad sobre otros modelos como GPT-4.5 o Claude.

Sin embargo, declaraciones como “el mejor chatbot del mundo” suelen formar parte de estrategias de marketing más que de afirmaciones objetivas basadas en resultados verificables.

Incluso Sam Altman, CEO de OpenAI, insinuó que su nuevo modelo, GPT-4.5, es un salto significativo en inteligencia artificial, aunque sin aportar pruebas concluyentes. Esto refuerza la idea de que las empresas utilizan el hype y las expectativas del público para ganar relevancia y atraer inversión.

Otro aspecto poco discutido en estas evaluaciones es la barrera del idioma. La mayoría de los chatbots están optimizados para funcionar mejor en inglés, obteniendo puntuaciones más altas en pruebas en este idioma. Sin embargo, al probarlos en español u otras lenguas menos dominantes en la tecnología, su rendimiento disminuye notablemente.

Hacia una IA más fiable

A pesar de sus limitaciones, los chatbots continúan evolucionando. Modelos como ChatGPT-o3 mini han mostrado cierta mejora en su capacidad de razonamiento, aunque aún están lejos de un entendimiento genuino.

La clave para avanzar en este campo no es simplemente hacer tests más complejos, sino diseñar pruebas que realmente evalúen la capacidad de razonar, en lugar de la habilidad de recordar información previa.

En las pruebas de los investigadores, además del único aprobado justo de GPT-o3 mini, el modelo que mejor se mantiene es DeepSeek R1-70b, ya que su rendimiento desciende menos que el del resto con el nuevo test.

Conoce cómo trabajamos en ComputerHoy.

Etiquetas: Inteligencia artificial

Deja un Comentario

Tu dirección de correo no será publicada. Los campos requeridos están marcados. *